Desde Twitter, que es la plataforma más atenta, a TikTok, que es un colador, ninguna gran compañía logra buena nota en un nuevo informe sobre la industria de la manipulación

Es como un menú. O el escaparate de un puesto en el mercado. El cliente llega y pide unas decenas de miles de me gusta en Instagram, unos cientos de comentarios en YouTube, unos miles de votos en una encuesta de Twitter o unos miles de seguidores en TikTok. Lo paga y al cabo de unos segundos o unas horas llegan al destino escogido. Así lo hicieron los investigadores del NATO StratCom CoE, un centro acreditado por la OTAN con sede en Letonia y financiado por varios países miembros. Los resultados aparecen en un informe sobre manipulación en Internet publicado este lunes con el título.

El NATO StratCom CoE creó entre septiembre y octubre 39 publicaciones anodinas en YouTube, Facebook, TikTok, Twitter e Instagram. Fueron al mercado de la manipulación y las engordaron a gusto: “Con 300 euros compramos 1.150 comentarios, 9.690 likes, 323.202 visualizaciones y 3.726 compartidos en Facebook, Instagram, YouTube, Twitter y TikTok, 337.768 en total”. Era su segundo experimento de este tipo. En 2019 observaron el funcionamiento de las webs que venden la manipulación. Este año se centraron en cómo reaccionan las grandes redes. ¿El resultado? Queda mucho por mejorar, aunque no todas las redes sacan la misma nota. “A pesar de las mejoras significativas de algunas redes, ninguna de las cinco plataformas hace suficiente para prevenir la manipulación de sus servicios”, dice el informe.

Nada de todo esto es nuevo. La manipulación existe desde que las redes empezaron a funcionar bien. La noticia hoy es que las redes siguen siendo incapaces de responder con eficacia. “El mercado de la manipulación sigue funcionando y la mayoría de pedidos son atendidos de manera puntual y precisa. La manipulación en redes sigue estando ampliamente disponible, es barata, es eficiente y continúa siendo empleada por antagonistas o aguafiestas que intentan influir en elecciones, polarizar la opinión pública, apartar legítimas discusiones políticas y manipular intereses comerciales online”, dice el informe en una de sus frases más elocuentes.

“No hay datos fuera de las empresas de redes sociales para evaluar cuánto contenido inauténtico hay”, dice Jānis Sārts, director del NATO StratCom CoE. “Nuestra estimación es que hay una cantidad razonable, en algunos casos y lugares hay muy poca pero en otros puede llegar a ser significativa”, añade.

Una de sus peores consecuencias es el peso que tiene en lo que vemos: los posts o vídeos con muchas interacciones alcanzan a más gente. Aunque las interacciones sean falsas, ver que algo ha tenido miles de clics equivale a impacto. La viralidad se puede comprar. Y los tutoriales para hacerlo están colgados en YouTube. “Es como si las instrucciones para robar el banco estuvieran en el tablón de la entrada al banco”, dice Sebastian Bay, uno de los autores del informe.

Las cuentas y los posts con mejores cifras tienen más opciones de captar nuestra atención. Es como si hace 30 años, por unos cientos de euros una marca o un cantante cualquiera pudiera haber comprado unos segundos de aparición en el Telediario. Los espectadores pensarían que está delante de sus ojos por méritos propios (una buena canción, una campaña graciosa), cuando en realidad lo que había hecho era comprar likes falsos.

Un mercado diverso

¿Qué tipos de usuarios compran estos servicios? Hay de todo, según el informe, que ha identificado 71 temas inflados en una semana, desde servicios financieros, política, salud o pornografía a apuestas, deportes e influencers. Hubo manipulación a favor de ambos partidos en las elecciones de Estados Unidos. Incluso encontraron bots hinchando las interacciones con una marca de “un gran artista estadounidense”. “Los tres proveedores de manipulación que usamos para el experimento dicen haber completado 17 millones de pedidos; uno de ellos con 27 empleados y sirviendo a más de 190.000 clientes habituales”, dice el informe. Esos 27 trabajadores son los que operan en las oficinas en Rusia con el software original pero, advierten los investigadores, también usan mano de obra en Asia para la mayor parte del trabajo manual necesario.

En el experimento probaron a hinchar dos posts no políticos de dos senadores estadounidenses en plenas elecciones. El objetivo era ver si las redes lo pillaban por estar en máxima alerta. No lo hicieron.

Las notas van del aprobado de Twitter y Facebook, al suspenso de Instagram y YouTube. TikTok ni siquiera fue al examen. “Ninguna interacción manipulada fue prevenida o eliminada por TikTok, convirtiéndola a mucha distancia en la más fácil de manipular”, dice el informe.

Los investigadores lograron identificar 8.036 cuentas falsas usadas para amplificar interacciones. Reportaron a las redes 499. No sirvió de nada. “Cinco días después, 482 seguían activas”, dicen. “En todos los casos en los que recibimos respuesta sobre las cuentas que reportamos, fue para decirnos que ese usuario no violaba los términos de servicio de la plataforma”. Es como si un ciudadano llevara a un ladrón a comisaría, les dijera que lo ha pillado robando en casa y los policías le dijeran que no hay pruebas. El informe advierte de que los bots ya no son cuentas solo puramente automatizadas. La industria manipuladora también crea cuentas con humanos detrás para mejorar sus servicios.

La escala del combate entre las redes es asombrosa. En sus informes trimestrales, Facebook dice que ha eliminado 4.500 millones de cuentas falsas en 2020 y que encontró más del 99% automáticamente, antes de que los usuarios las reportaran. ¿Cuántas se les han escapado? Nadie lo sabe. “Hemos encontrado servicios de manipulación que ofrecen hasta 10 millones de visualizaciones en Twitter y Facebook, 50 millones en Instagram y hasta 100 en Instagram TV”, dice el informe.

Sārts se muestra crítico con las plataformas, pero ve cierta esperanza en nuevas regulaciones externas. “La Unión Europea se está volviendo más activa con la introducción de la Ley de Servicios Digitales”, dice. Observa a su vez un problema grave: “La manipulación sigue siendo demasiado accesible. Estas plataformas pueden ser explotadas para atizar las emociones de la gente y ahondar en sus vulnerabilidades”.

Diferencias por redes sociales

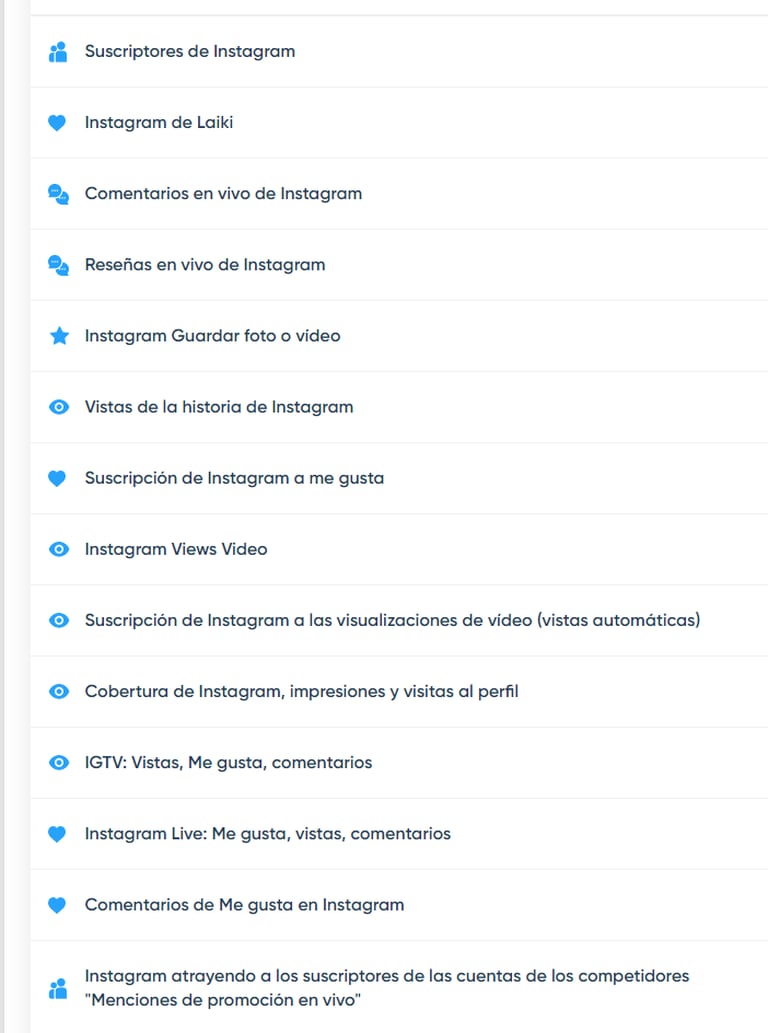

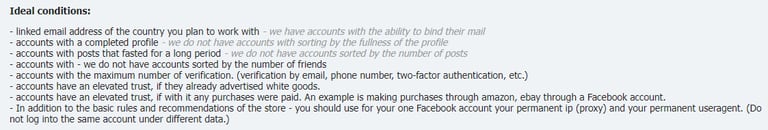

El informe reserva un apartado para la actuación de cada compañía para suprimir interacciones y cuentas falsas. Twitter sigue siendo la mejor red combatiendo este tipo de manipulación. “Aunque los likes que compramos aparecieron en una hora, el 80% había desaparecido 24 horas después”, dice el informe. En cambio, la creación de cuentas falsas es tremendamente sencilla en Twitter: “Ninguna de nuestras cuentas fue bloqueada este año y observamos menos contramedidas en 2020 que en 2019”. Facebook es justo al contrario: es mucho mas difícil crear cuentas falsas. Las empresas de manipulación ofrecen tutoriales sobre cómo sobrevivir en Facebook. En cambio, las interacciones falsas sobreviven más tiempo, aunque también son más difíciles de crear. “Hemos observado una reducción en la velocidad de la entrega de la manipulación, especialmente para comentarios falsos, lo que indica que los proveedores ya no pueden automatizarlos”, dice el informe.

Facebook no ha querido comentar la publicación de este informe. El jefe de Integridad de Twitter, Yoel Roth, ve señales positivas en sus conclusiones. “Nos anima que el informe reconozca nuestro trabajo como líderes de la industria al combatir la manipulación de la plataforma”, dice Roth. “Con el uso a la vez de tecnología y revisión humana, enfrentamos activamente los intentos de manipulación de la plataforma y los mitigamos a escala”, añade.

Igual que el informe señala el esfuerzo notable de mejora de Facebook, también resalta el desastre que es Instagram, propiedad de Facebook. “Manipular Instagram sigue siendo barato y eficaz”, dice el informe. Uno de los factores clave para comprobarlo es el precio de la manipulación: Instagram es la más barata de manipular, más incluso que TikTok.

Según el informe, TikTok es el patito feo de la manipulación online. “Concluimos que TikTok es demasiado fácil de manipular, tan fácil que la mejor manera de describir la plataforma es simplemente como indefensa”, dice el informe. El punto positivo de TikTok, según el estudio, es que hace parecer mejores a las otras redes. El precio de 1.000 visualizaciones falsas en TikTok es de 0,11 euros de media, similar a Instagram. Los comentarios salen a 2 euros por cada 100. A estos precios los comentarios que se compran son en cualquier lengua. En la lengua original salen más caros.

En un comunicado, TikTok no está de acuerdo con esta caracterización. “TikTok tiene tolerancia cero respecto a comportamientos falsos o engañosos en la plataforma, y eliminamos el contenido o las cuentas que promueven el spam o las interacciones falsas”, dice la compañía china. “Estamos invirtiendo en pruebas realizadas por terceros, tecnologías automatizadas y políticas amplias para adelantarnos a las siempre cambiantes tácticas que utilizan quienes tienen como objetivo engañar a los demás”, añade.

YouTube es la plataforma que mejor combate las visualizaciones falsas, algo que en Instagram, Facebook y Twitter es una batalla perdida. Pero ahí acaba el éxito de YouTube. Por su falta de transparencia, es imposible determinar las cuentas usadas para crear el contenido falso, dice el informe. “Al añadir TikTok este año, YouTube perdió la distinción de ser la peor plataforma, pero solo porque TikTok es aún peor”, concluye el informe.

En un comunicado de la compañía, dicen que las políticas de la plataforma no permiten la manipulación. “Nuestra política sobre interacciones falsas no permite inflar artificialmente las visualizaciones de videos, los Me gusta o los comentarios. Usamos tecnología propia para prevenir este tipo de actividad artificial en nuestra plataforma y solo en el tercer trimestre de 2020 se han eliminado más de dos millones de vídeos por violar nuestras políticas de spam”, dice la compañía, propiedad de Alphabet, empresa madre de Google. Pero no está claro qué impacto tienen sobre la manipulación como tal: “Cuando corresponde, eliminamos las interacciones fraudulentas y tomamos otras medidas contra los canales infractores”.